Il Cloud and Threat Report di quest'anno sulle app di IA si concentra in particolare sulle tendenze e sui rischi delle applicazioni genAI, poiché l'uso di genAI è cresciuto rapidamente con ampia portata e un impatto ampio sugli utenti enterprise. Il 96% delle organizzazioni intervistate ha utenti che utilizzano GenAI, con il numero di utenti che è triplicato negli ultimi 12 mesi. L'uso reale delle app GenAI include aiuto con la programmazione, l'assistenza alla scrittura, la creazione di presentazioni e la generazione di video e immagini. Questi casi d'uso presentano sfide per la sicurezza dei dati, in particolare come prevenire che dati sensibili, come il codice sorgente, i dati regolamentati e la proprietà intellettuale, vengano inviati ad app non approvate.

Iniziamo questo rapporto esaminando le tendenze di utilizzo delle applicazioni genAI, quindi analizziamo i rischi generali introdotti dall'uso di genAI, discutiamo controlli specifici che sono efficaci e possono aiutare le organizzazioni a migliorare di fronte a dati incompleti o New aree di minaccia, e concludiamo con uno sguardo alle tendenze e alle implicazioni future.

Sulla base di milioni di attività degli utenti anonimizzate, l'utilizzo dell'app genAI ha subito cambiamenti significativi da giugno 2023 a giugno 2024:

- Praticamente tutte le organizzazioni ora utilizzano applicazioni genAI, con un utilizzo che è aumentato dal 74% al 96% delle organizzazioni nell'ultimo anno.

- L'adozione di GenAI sta crescendo rapidamente e non ha ancora raggiunto uno stato stabile. L'organizzazione media utilizza più di tre volte il numero di app genAI e ha quasi tre volte più utenti che utilizzano attivamente queste app rispetto a un anno fa.

- Il rischio per i dati è una priorità per i primi utilizzatori di app genAI, con la condivisione di codice sorgente proprietario con app genAI che rappresenta il 46% di tutte le violazioni delle policy sui dati.

- L'adozione di controlli di sicurezza per abilitare in sicurezza le app genAI è in aumento, con più di tre quarti delle organizzazioni che utilizzano Policy/allow Policy, DLP, coaching live per gli utenti e altri controlli per abilitare le app genAI proteggendo i dati.

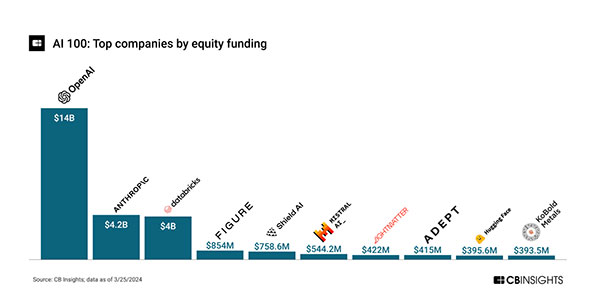

L’intelligenza artificiale in generale è stata popolare e ha attirato investimenti considerevoli, con finanziamenti per un totale di oltre 28 miliardi di dollari in oltre 240 accordi azionari dal 2020 al 22/03/2024.[1]

Con OpenAI e Anthropic che totalizzano quasi due terzi (64%) dei finanziamenti totali, i finanziamenti per l'IA sono dominati e guidati dall'IA di genere. Ciò riflette il crescente entusiasmo per genAI dopo il rilascio di ChatGPT da parte di OpenAI nel novembre 2022. Oltre alle startup, sono stati creati numerosi ETF e fondi comuni di investimento incentrati sull'intelligenza artificiale, il che indica un ulteriore livello di finanziamento da parte degli investitori del mercato pubblico. L'ingente ammontare di investimenti darà impulso alla ricerca e allo sviluppo, al lancio dei prodotti e ai rischi e abusi associati.

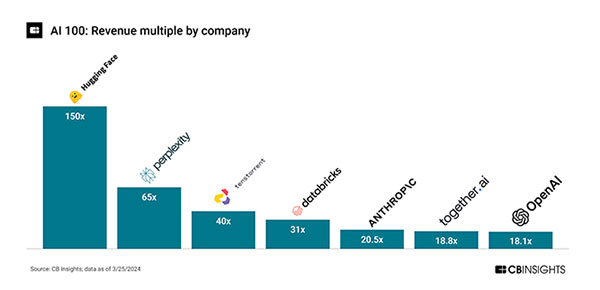

Rapporti prezzo/vendite sovradimensionati indicano che l'esecuzione è in ritardo rispetto alle alte aspettative degli investitori. Hugging Face ha un multiplo di 150 volte una valutazione di 4,5 miliardi di dollari su ricavi da 30 milioni e Perplexity un multiplo di 65 volte rispetto a una valutazione di 520 milioni su ricavi di 8 milioni didollari[1]:

Sebbene i ricavi reali siano in ritardo, l'attività di rilascio dei prodotti è elevata, indicando che siamo ancora agli inizi del ciclo di innovazione nell'IA con un forte investimento in R&S. Ad esempio, ci sono state 34 rilasci di funzionalità (minori e maggiori) di ChatGPT da novembre 2022[2], ovvero circa due al mese.

È chiaro che la genAI sarà il motore degli investimenti in IA nel breve termine e introdurrà il rischio e l'impatto più ampi per gli utenti aziendali. È o sarà integrato di default sulle principali piattaforme applicative, di ricerca e di dispositivi, con casi d'uso come ricerca, revisione di copie, regolazione di stile/tono e creazione di contenuti. Il rischio principale deriva dai dati che gli utenti inviano alle app, inclusa la perdita di dati, la condivisione involontaria di informazioni riservate e l'uso inappropriato di informazioni (diritti legali) dai servizi genAI. Attualmente, il testo (LLM) è usato di più, con i loro casi d'uso più ampi, anche se le app genAI per video, immagini e altri media sono anch'esse un fattore.

Questo rapporto riassume l'utilizzo e le tendenze di genAI sulla base di dati anonimizzati dei clienti negli ultimi 12 mesi, descrivendo in dettaglio l'utilizzo dell'applicazione, le azioni degli utenti, le aree di rischio e i controlli iniziali, fornendo al contempo indicazioni prescrittive per i prossimi 12 mesi.