Alla base, MCP è uno standard aperto che determina come le applicazioni forniscono contesto agli LLM. Immagina MCP come una porta USB-C per applicazioni di IA. Così come USB-C offre un modo standardizzato per collegare dispositivi a varie periferiche, MCP fornisce un'interfaccia coerente per i modelli di IA per interagire con fonti di dati e strumenti diversi. Questo protocollo facilita la costruzione di agenti intelligenti e flussi di lavoro complessi sopra gli LLM, offrendo una lista sempre più ampia di integrazioni predefinite a cui gli LLM possono collegarsi direttamente, offrendo la flessibilità di passare da un provider LLM all'altro e stabilendo le migliori pratiche per proteggere i dati all'interno della tua infrastruttura.

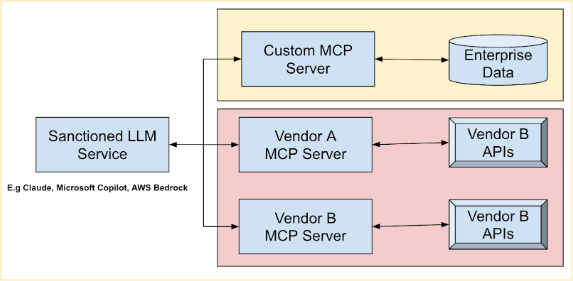

L'architettura generale di MCP segue un modello client-server, in cui un'applicazione host si collega a più server MCP. Questi server sono programmi leggeri che espongono capacità specifiche tramite l'MCP standardizzato. Agiscono come intermediari tra host MCP (strumenti AI come Claude Desktop o IDEs), client MCP (client di protocollo che mantengono le connessioni), sorgenti dati locali (file, database) e servizi remoti (API esterne). LLM popolari come Anthropic Claude Models, Microsoft Azure Foundation Models, Amazon Bedrock Foundation Models e Google Foundation (Gemini) Models possono sfruttare i tuoi strumenti esistenti e combinare dati vitali di più fornitori tramite questi server. Questo consente un'automazione fluida dei flussi di lavoro, risparmiando tempo e migliorando la precisione operativa.

FastMCP offre un approccio snello alla costruzione del proprio server MCP. Utilizzando elementi di metodo come '@tool', puoi facilmente incapsulare le tue API e dati, rendendoli accessibili tramite un server MCP. Ad esempio, ecco un semplice estratto di codice da FastMCP che dimostra un server MCP che aggiunge due numeri:

Indietro

Indietro