今年の AI アプリに関するクラウドと脅威レポートでは、genAI の使用が急速に拡大し、企業ユーザーに広範囲に及んで大きな影響を与えていることから、genAI アプリケーションの傾向とリスクに特に焦点を当てています。 調査対象となった組織の 96% に genAI を使用しているユーザーがおり、過去 12 か月間でユーザー数は 3 倍に増加しています。 genAIアプリの実際の使用には、コーディング、ライティング支援、プレゼンテーションの作成、ビデオと画像の生成の支援が含まれます。 これらのユースケースでは、データ セキュリティの課題、具体的にはソース コード、規制対象データ、知的財産などの機密データが承認されていないアプリに送信されないようにする方法が提示されます。

このレポートでは、まず genAI アプリケーションの使用傾向について検討し、次に genAI の使用によってもたらされる広範なリスクを分析し、不完全なデータや新しい脅威領域に直面した場合に組織の改善に役立つ効果的な特定の制御について説明し、最後に将来の傾向と影響について検討します。

何百万もの匿名化されたユーザーアクティビティに基づいて、genAIアプリの使用は2023年6月から2024年6月にかけて大きな変化を遂げました。

- 現在、ほぼすべての組織が genAI アプリケーションを使用しており、過去 1 年間で使用組織は 74% から 96% に増加しています。

- GenAIの採用は急速に拡大しており、まだ安定した状態には達していません。 平均的な組織では、1 年前と比べて genAI アプリの数が 3 倍以上増加し、それらのアプリをアクティブに使用しているユーザー数もほぼ 3 倍になっています。

- データ リスクは、genAI アプリの早期導入者にとって最大の懸念事項であり、genAI アプリとの独自のソース コードの共有が、すべてのデータ ポリシー違反の 46% を占めています。

- genAI アプリを安全に有効化するためのセキュリティ制御の導入が増加しており、4 分の 3 以上の組織が、ブロック/許可ポリシー、DLP、ライブ ユーザー コーチング、その他の制御を使用して、データを保護しながら genAI アプリを有効にしています。

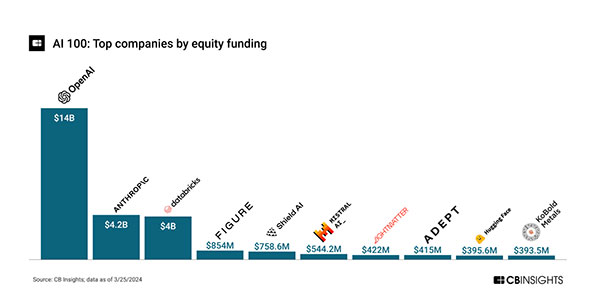

AIは一般的に人気があり、かなりの投資を引き付けており、2020年から2024年3月22日までの240+株式取引で合計280億ドル以上の資金が調達されました。[1]

OpenAIとAnthropicが総資金調達の約3分の2(64%)を占めており、AIの資金調達はgenAIによって支配され、推進されています。 これは、2022年11月にOpenAIがChatGPTをリリースして以来、genAIの興奮が高まっていることを反映しています。 スタートアップだけでなく、AIに特化したETFや投資信託が複数作られており、公開市場の投資家からの資金調達がさらにレベルアップしていることを示しています。 この多額の投資は、研究開発、製品のリリース、および関連するリスクや乱用にとって追い風となります。

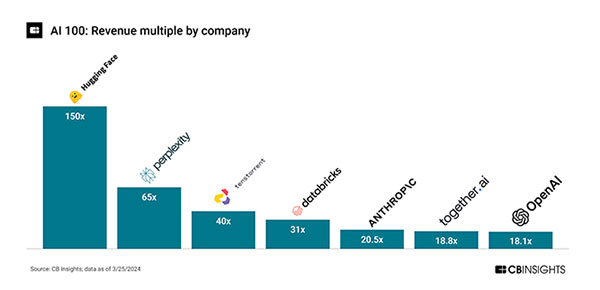

株価売上高倍率(PER)が桁外れであることは、執行が投資家の高い期待に遅れをとっていることを示しています。 Hugging Faceは、$30Mの収益に対して$4.5Bの評価額の150倍の倍数を持ち、Perplexityは$8Mの収益に対して$520Mの評価額の65倍の倍数を持っています[1]。

実質収益は遅れているものの、製品のリリース活動は高く、AIイノベーションサイクルの初期段階にあり、多額の研究開発投資を行っていることを示しています。 例えば、2022年11月以降、ChatGPTの機能リリース(マイナーとメジャー)は34回(マイナーとメジャー)あり[2]、月に約2回リリースされています。

genAIが短期的にはAI投資の原動力となり、企業ユーザーに最も広範なリスクと影響をもたらすことは明らかです。 これは、検索、コピー編集、スタイル/トーンの調整、コンテンツ作成などのユースケースで、主要なアプリケーション、検索、デバイス プラットフォームにデフォルトでバンドルされているか、バンドルされる予定です。 主なリスクは、データの損失、機密情報の意図しない共有、genAIサービスからの情報の不適切な使用(法的権利)など、ユーザーがアプリに送信するデータに起因します。 現在、テキスト (LLM) はより幅広いユースケースで多く使用されていますが、ビデオ、画像、その他のメディア用の genAI アプリも要因となっています。

このレポートでは、過去 12 か月間の匿名化された顧客データに基づいて genAI の使用状況と傾向をまとめ、アプリケーションの使用、ユーザーのアクション、リスク領域、早期管理の詳細を説明するとともに、今後 12 か月間の指針となるガイダンスを提供します。