Im Kern handelt es sich bei MCP um einen offenen Standard, der vorschreibt, wie Anwendungen Kontext für LLMs bereitstellen. Stellen Sie sich MCP als USB-C-Anschluss für KI-Anwendungen vor. So wie USB-C eine standardisierte Möglichkeit bietet, Geräte mit verschiedenen Peripheriegeräten zu verbinden, bietet MCP eine konsistente Schnittstelle für KI-Modelle, um mit verschiedenen Datenquellen und Tools zu interagieren. Dieses Protokoll erleichtert die Erstellung intelligenter Agenten und komplexer Workflows auf LLMs, indem es eine wachsende Liste vorgefertigter Integrationen bietet, in die LLMs direkt eingebunden werden können, die Flexibilität bietet, zwischen LLM-Anbietern zu wechseln, und Best Practices für die Sicherung Ihrer Daten in Ihrer Infrastruktur etabliert.

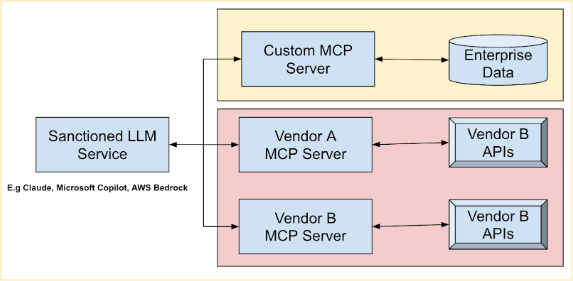

Die allgemeine Architektur von MCP folgt einem Client-Server-Modell, bei dem eine Hostanwendung eine Verbindung zu mehreren MCP-Servern herstellt. Bei diesen Servern handelt es sich um leichtgewichtige Programme, die bestimmte Funktionen über das standardisierte MCP verfügbar machen. Sie fungieren als Vermittler zwischen MCP-Hosts (KI-Tools wie Claude Desktop oder IDEs), MCP-Clients (Protokollclients, die Verbindungen aufrechterhalten), lokalen Datenquellen (Dateien, Datenbanken) und Remote-Diensten (externe APIs). Beliebte LLMs wie Anthropic Claude Models, Microsoft Azure Foundation Models, Amazon Bedrock Foundation Models und Google Foundation (Gemini) Models können Ihre vorhandenen Tools nutzen und wichtige Daten von mehreren Anbietern über diese Server kombinieren. Dies ermöglicht eine nahtlose Automatisierung von Arbeitsabläufen, spart Zeit und verbessert die Betriebsgenauigkeit.

Schnelles MCP bietet einen optimierten Ansatz zum Erstellen eines eigenen MCP-Servers. Durch die Verwendung von Methodendekorationen wie "@tool" können Sie Ihre APIs und Daten mühelos umschließen und sie über einen MCP-Server zugänglich machen. Hier ist zum Beispiel ein einfacher Codeausschnitt von FastMCP, der einen MCP-Server demonstriert, der zwei Zahlen hinzufügt:

Zurück

Zurück