En esencia, MCP es un estándar abierto que dicta cómo las aplicaciones proporcionan contexto a los LLM. Imagine MCP como un puerto USB-C para aplicaciones de IA. Al igual que USB-C ofrece una forma estandarizada de conectar el dispositivo a varios periféricos, MCP proporciona una interfaz coherente para que los modelos de IA interactúen con diversas fuentes y herramientas de datos. Este protocolo facilita la creación de agentes inteligentes y flujos de trabajo complejos sobre los LLM, ya que ofrece una lista cada vez mayor de integraciones prediseñadas a las que los LLM pueden conectarse directamente, proporcionando la flexibilidad para cambiar entre proveedores de LLM y estableciendo las mejores prácticas para proteger sus datos dentro de su infraestructura.

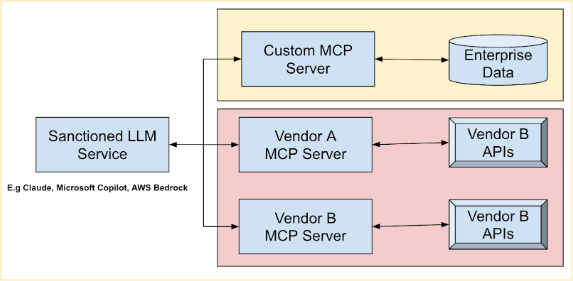

La arquitectura general de MCP sigue un modelo cliente-servidor, donde una aplicación host se conecta a varios servidores MCP. Estos servidores son programas ligeros que exponen capacidades específicas a través del MCP estandarizado. Actúan como intermediarios entre los hosts MCP (herramientas de IA como Claude Desktop o IDE), los clientes MCP (clientes de protocolo que mantienen conexiones), las fuentes locales de Datos (archivos, bases de datos) y los servicios remotos (API externas). Los LLM populares, como los modelos Anthropic Claude, los modelos de Microsoft Azure Foundation, los modelos de Amazon Bedrock Foundation y los modelos de Google Foundation (Gemini), pueden aprovechar sus herramientas existentes y combinar datos vitales de varios proveedores a través de estos servidores. Esto permite una automatización perfecta del flujo de trabajo, ahorrando tiempo y mejorando la precisión operativa.

FastMCP (en inglés) proporciona un enfoque simplificado para crear su propio servidor MCP. Mediante decoraciones del método Usar como '@tool', puede envolver sin esfuerzo sus API y Datos, haciéndolos accesibles a través de un servidor MCP. Por ejemplo, aquí hay un fragmento de código simple de FastMCP que demuestra un servidor MCP que agrega dos números:

Atrás

Atrás