Em sua essência, o MCP é um padrão aberto que determina como os aplicativos fornecem contexto aos LLMs. Imagine o MCP como uma porta USB-C para aplicativos de IA. Assim como o USB-C oferece uma maneira padronizada de conectar dispositivos a vários periféricos, o MCP fornece uma interface consistente para os modelos de IA interagirem com diversas fontes de dados e ferramentas. Esse protocolo facilita a criação de agentes inteligentes e fluxos de trabalho complexos sobre LLMs, oferecendo uma lista crescente de integrações pré-construídas às quais os LLMs podem se conectar diretamente, fornecendo a flexibilidade de alternar entre provedores de LLMs e estabelecendo as melhores práticas para proteger seus dados em sua infraestrutura.

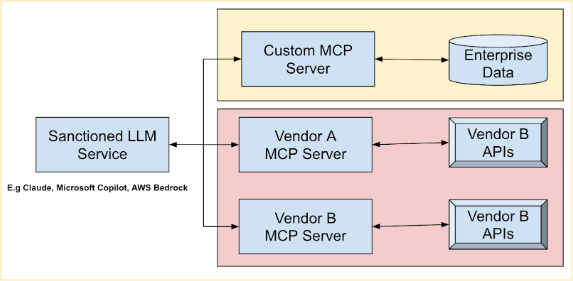

A arquitetura geral do MCP segue um modelo cliente-servidor, em que um aplicativo host se conecta a vários servidores MCP. Esses servidores são programas leves que expõem recursos específicos por meio do MCP padronizado. Eles atuam como intermediários entre hosts MCP (ferramentas de IA como Claude Desktop ou IDEs), clientes MCP (clientes de protocolo que mantêm conexões), fontes de dados locais (arquivos, bancos de dados) e serviços remotos (APIs externas). LLMs populares, como Anthropic Claude Models, Microsoft Azure Foundation Models, Amazon Bedrock Foundation Models e Google Foundation (Gemini), podem aproveitar suas ferramentas existentes e combinar dados vitais de vários fornecedores por meio desses servidores. Isso permite uma automação perfeita do fluxo de trabalho, economizando tempo e melhorando a precisão operacional.

MCP rápido fornece uma abordagem simplificada para criar seu próprio servidor MCP. Ao usar decorações de método como `@tool`, você pode facilmente agrupar suas APIs e dados, tornando-os acessíveis por meio de um servidor MCP. Por exemplo, aqui está um trecho de código simples do FastMCP demonstrando um servidor MCP que adiciona dois números:

Voltar

Voltar