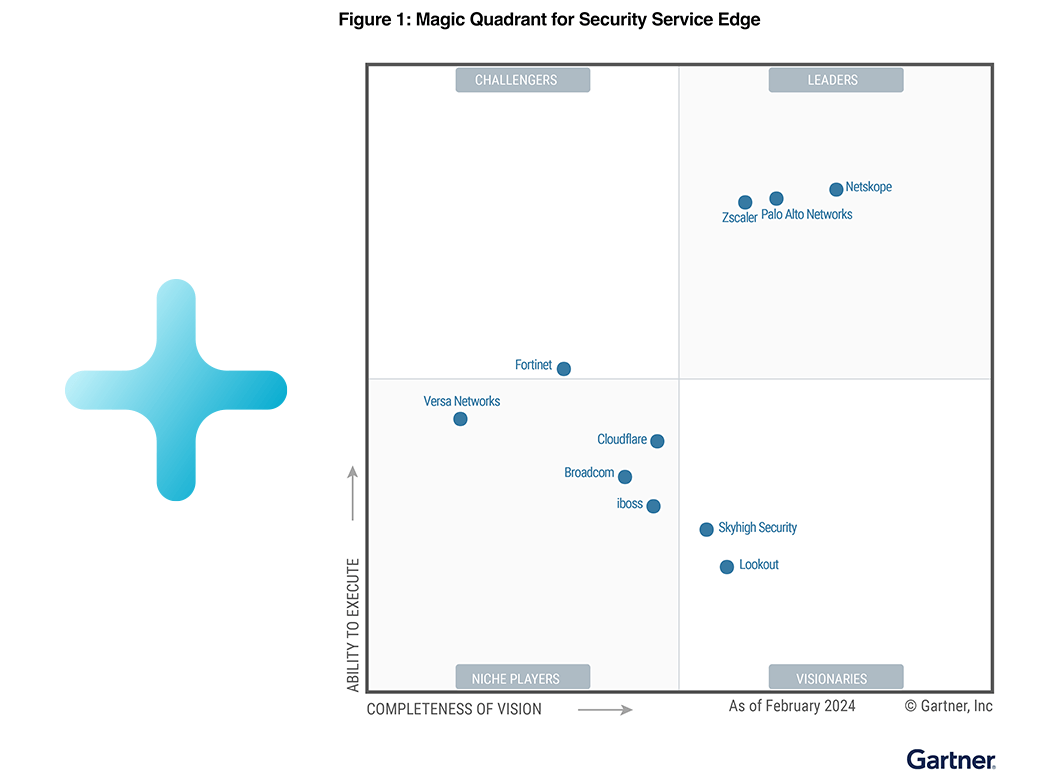

Netskope named a Leader in the 2024 Gartner® Magic Quadrant™ for Security Service Edge. Get the report

-

Netskopeが選ばれる理由

- Netskopeが選ばれる理由

Netskopeが選ばれる理由

ネットワークとセキュリティの連携方法を変える。

レポートを読むStill Highest in Execution.

Still Furthest in Vision.Learn why 2024 Gartner® Magic Quadrant™ named Netskope a Leader for Security Service Edge the third consecutive year.

- Netskopeが選ばれる理由

導入企業

Netskope は世界中で 3,000 を超える顧客にサービスを提供しており、その中にはフォーチュン 100 企業の 25 以上が含まれます

- Netskopeが選ばれる理由

パートナー

私たちはセキュリティリーダーと提携して、クラウドへの旅を保護します。

Netskope パートナーについて学ぶNetskopeのパートナー中心の市場開拓戦略により、パートナーは企業のセキュリティを変革しながら、成長と収益性を最大化できます。

-

プラットフォーム

- プラットフォーム

Netskope One プラットフォーム

Netskope One は、セキュリティとネットワークをサービスとして統合したプラットフォームです。

ホワイトペーパーはこちら明日に向けたネットワークサポートするアプリケーションとユーザー向けに設計された、より高速で、より安全で、回復力のあるネットワークへの道を計画します。

- プラットフォーム

Netskope One プラットフォームの機能

Netskope One は、超高速と信頼性の高い回復力により、ビジネスの俊敏性を高めます。

Netskope One について学ぶNetskope One プラットフォームの紹介Netskope One は、SASE とゼロトラスト変革を可能にする統合型セキュリティおよびネットワーキング サービスを提供するクラウドネイティブ プラットフォームです。

- プラットフォーム

NewEdge

NewEdgeは、世界最大かつ最高のパフォーマンスを誇るセキュリティプライベートクラウドです。

NewEdgeの詳細セキュアアクセスサービスエッジ(SASE)アーキテクチャの採用Netskope NewEdgeは、世界最大かつ最高のパフォーマンスのセキュリティプライベートクラウドであり、比類のないサービスカバレッジ、パフォーマンス、および回復力を顧客に提供します。

- プラットフォーム

技術パートナーと統合

Netskopeは、エンタープライズテクノロジーの最強の企業と提携しています。

Cloud Exchangeについて学ぶNetskope Cloud ExchangeNetskope Cloud Exchange (CE) は、セキュリティポスチャに対する投資を活用するための強力な統合ツールを提供します。

-

製品

- 製品

セキュリティサービスエッジ製品

高度なクラウド対応の脅威から保護し、あらゆるベクトルにわたってデータを保護

製品概要はこちら未来のプラットフォームはNetskopeですインテリジェントセキュリティサービスエッジ(SSE)、クラウドアクセスセキュリティブローカー(CASB)、クラウドファイアウォール、セキュアウェブゲートウェイ(SWG)、およびZTNAのプライベートアクセスは、単一のソリューションにネイティブに組み込まれており、セキュアアクセスサービスエッジ(SASE)アーキテクチャへの道のりですべてのビジネスを支援します。

- 製品

Borderless SD-WAN

すべてのリモートユーザー、デバイス、サイト、クラウドへ安全で高性能なアクセスを提供

Next Gen SASE Branchの詳細はこちらNext Gen SASE Branch はハイブリッドである:接続、保護、自動化Netskope Next Gen SASE Branchは、コンテキストアウェアSASEファブリック、ゼロトラストハイブリッドセキュリティ、 SkopeAI-Powered Cloud Orchestrator を統合クラウド製品に統合し、ボーダレスエンタープライズ向けに完全に最新化されたブランチエクスペリエンスを実現します。

- Borderless SD-WAN

- 次世代SASEブランチ

- Secure SD-WAN

- Endpoint SD-WAN

- Micro Branch

- ワイヤレスWAN

- マルチクラウドネットワーキング

- IoT Intelligent Access

- Borderless SD-WAN

- 製品

Secure Access Service Edge

Netskope One SASE は、クラウドネイティブで完全に統合された単一ベンダーの SASE ソリューションを提供します。

電子書籍を入手するSASEアーキテクチャの設計 For DummiesSASE設計について網羅した電子書籍を無償でダウンロード

-

ソリューション

- ソリューション

ネットワークトランスフォーメーション

デジタルトランスフォーメーションを通してアジリティと効率化を実現

ソリューション概要はこちらNewEdgeの詳細最小の遅延と高い信頼性を備えた、市場をリードするクラウドセキュリティサービスに移行します。 - ソリューション

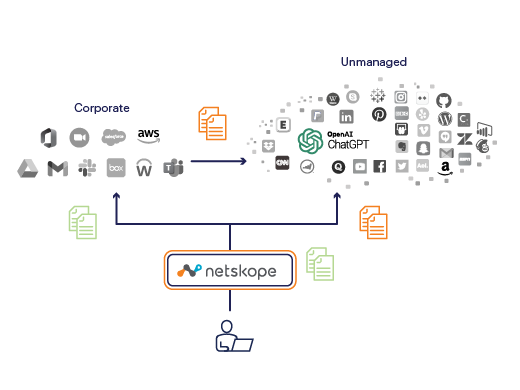

セキュリティの最新化

現在と未来のセキュリティの課題に対応

生成AIの使用を保護する方法を学ぶアプリケーションのアクセス制御、リアルタイムのユーザーコーチング、クラス最高のデータ保護により、生成型AIアプリケーションを安全に使用できるようにします。- 高度な脅威対策

- データ保護

- ハイブリッドワーク

- インサイダーリスク

- クラウドのコンプライアンスを維持する

- VPNを交換する

- ChatGPTと生成AIを安全に有効にする

- 安全なマネージドクラウドアプリケーション

- 管理されていないクラウドアプリケーションを保護する

- AWS、Azure & GCP

- 高度な脅威対策

- ソリューション

フレームワーク

サイバーセキュリティ規制の枠組みを採用

- ソリューション

政府と産業

Netskope、大手代理店や企業のクラウド移行保護を支援

すべての業界を見るNetskope GovCloud について学ぶNetskopeがFedRAMPの高認証を達成政府機関の変革を加速するには、Netskope GovCloud を選択してください。

-

リソース

- リソース

リソース

クラウドへ安全に移行する上でNetskopeがどのように役立つかについての詳細は、以下をご覧ください。

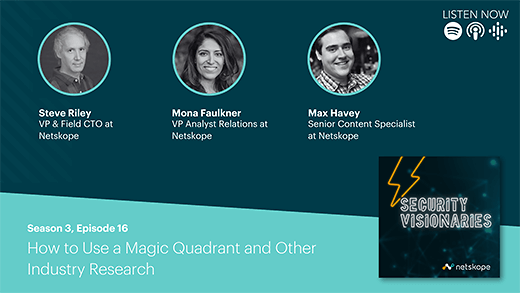

ポッドキャストを再生する「セキュリティビジョナリー」ポッドキャストHow to Use a Magic Quadrant and Other Industry Research

このエピソードでは、マックス・ヘイビー、スティーブ・ライリー、モナ・フォークナーが、マジック・クアドラントを作成する複雑なプロセスと、それが単なるチャート以上のものである理由を分析します。 - リソース

ブログ

Netskope がセキュリティ サービス エッジ (SSE) を通じてセキュリティとネットワークの変革を実現する方法を学びます

ブログを読む最新のブログNetskope がセキュリティ サービス エッジ (SSE) 機能を通じてゼロ トラストと SASE の導入をどのように実現できるかをご覧ください。

- リソース

イベント&ワークショップ

最新のセキュリティトレンドを先取りし、仲間とつながりましょう。

セッションの詳細SASE Week 2023年:SASEの旅が今始まります!第4回 SASE Weekのリプレイセッション。

- リソース

定義されたセキュリティ

サイバーセキュリティ百科事典、知っておくべきすべてのこと

セキュリティサービスエッジの詳細セキュリティサービスエッジとはSASEのセキュリティ面、ネットワークとクラウドでの保護の未来を探ります。

-

会社概要

- 会社概要

会社概要

クラウド、データ、ネットワークセキュリティの課題に対して一歩先を行くサポートを提供

詳しくはこちらデータセキュリティによる持続可能性のサポートNetskope は、持続可能性における民間企業の役割についての認識を高めることを目的としたイニシアチブである「ビジョン2045」に参加できることを誇りに思っています。

- 会社概要

リーダーシップ

Netskopeの経営陣はお客様を成功に導くために全力を尽くしています。

当社のチーム紹介思想家、建築家、夢想家、革新者。 一緒に、私たちはお客様がデータと人々を保護するのを助けるために最先端のクラウドセキュリティソリューションを提供します。 - 会社概要

カスタマーソリューション

お客様の成功のために、Netskopeはあらゆるステップを支援いたします。

カスタマーソリューションに移動プロフェッショナルサービスについて学ぶNetskopeの有能で経験豊富なプロフェッショナルサービスチームは、実装を成功させるための規範的なアプローチを提供します。 - 会社概要

トレーニングと認定

Netskopeのトレーニングで、クラウドセキュリティのスキルを学ぶ

トレーニングと認定資格について学ぶNetskopeトレーニングで、デジタルトランスフォーメーションの旅を保護し、クラウド、ウェブ、プライベートアプリケーションを最大限に活用してください。- Netskope Security Cloud初心者向けオンライントレーニング

- Netskope Security Cloudの運用と管理

- Netskope Security Cloudの実装と統合

- Netskopeクラウドセキュリティ認定プログラム

- Netskope Security Cloud初心者向けオンライントレーニング

- Netskopeが選ばれる理由

ネットワークとセキュリティの連携方法を変える。

- 導入企業

Netskope は世界中で 3,000 を超える顧客にサービスを提供しており、その中にはフォーチュン 100 企業の 25 以上が含まれます

- パートナー

私たちはセキュリティリーダーと提携して、クラウドへの旅を保護します。

Still Furthest in Vision.

Learn why 2024 Gartner® Magic Quadrant™ named Netskope a Leader for Security Service Edge the third consecutive year.

レポートを読む

- Netskope One プラットフォーム

Netskope One は、セキュリティとネットワークをサービスとして統合したプラットフォームです。

- Netskope One プラットフォームの機能

Netskope One は、超高速と信頼性の高い回復力により、ビジネスの俊敏性を高めます。

- NewEdge

NewEdgeは、世界最大かつ最高のパフォーマンスを誇るセキュリティプライベートクラウドです。

- 技術パートナーと統合

Netskopeは、エンタープライズテクノロジーの最強の企業と提携しています。

Netskope One は、SASE とゼロトラスト変革を可能にする統合型セキュリティおよびネットワーキング サービスを提供するクラウドネイティブ プラットフォームです。

Netskope One について学ぶ

Netskope NewEdgeは、世界最大かつ最高のパフォーマンスのセキュリティプライベートクラウドであり、比類のないサービスカバレッジ、パフォーマンス、および回復力を顧客に提供します。

NewEdgeの詳細

Netskope Cloud Exchange (CE) は、セキュリティポスチャに対する投資を活用するための強力な統合ツールを提供します。

Cloud Exchangeについて学ぶ

- セキュリティサービスエッジ製品

高度なクラウド対応の脅威から保護し、あらゆるベクトルにわたってデータを保護

- Borderless SD-WAN

すべてのリモートユーザー、デバイス、サイト、クラウドへ安全で高性能なアクセスを提供

- Secure Access Service Edge

Netskope One SASE は、クラウドネイティブで完全に統合された単一ベンダーの SASE ソリューションを提供します。

インテリジェントセキュリティサービスエッジ(SSE)、クラウドアクセスセキュリティブローカー(CASB)、クラウドファイアウォール、セキュアウェブゲートウェイ(SWG)、およびZTNAのプライベートアクセスは、単一のソリューションにネイティブに組み込まれており、セキュアアクセスサービスエッジ(SASE)アーキテクチャへの道のりですべてのビジネスを支援します。

製品概要はこちら

Netskope Next Gen SASE Branchは、コンテキストアウェアSASEファブリック、ゼロトラストハイブリッドセキュリティ、 SkopeAI-Powered Cloud Orchestrator を統合クラウド製品に統合し、ボーダレスエンタープライズ向けに完全に最新化されたブランチエクスペリエンスを実現します。

Next Gen SASE Branchの詳細はこちら

- ネットワークトランスフォーメーション

デジタルトランスフォーメーションを通してアジリティと効率化を実現

- セキュリティの最新化

現在と未来のセキュリティの課題に対応

- フレームワーク

サイバーセキュリティ規制の枠組みを採用

- 政府と産業

Netskope、大手代理店や企業のクラウド移行保護を支援

- リソース

クラウドへ安全に移行する上でNetskopeがどのように役立つかについての詳細は、以下をご覧ください。

- ブログ

Netskope がセキュリティ サービス エッジ (SSE) を通じてセキュリティとネットワークの変革を実現する方法を学びます

- イベント&ワークショップ

最新のセキュリティトレンドを先取りし、仲間とつながりましょう。

- 定義されたセキュリティ

サイバーセキュリティ百科事典、知っておくべきすべてのこと

How to Use a Magic Quadrant and Other Industry Research

このエピソードでは、マックス・ヘイビー、スティーブ・ライリー、モナ・フォークナーが、マジック・クアドラントを作成する複雑なプロセスと、それが単なるチャート以上のものである理由を分析します。

- 会社概要

クラウド、データ、ネットワークセキュリティの課題に対して一歩先を行くサポートを提供

- リーダーシップ

Netskopeの経営陣はお客様を成功に導くために全力を尽くしています。

- カスタマーソリューション

お客様の成功のために、Netskopeはあらゆるステップを支援いたします。

- トレーニングと認定

Netskopeのトレーニングで、クラウドセキュリティのスキルを学ぶ

Netskope は、持続可能性における民間企業の役割についての認識を高めることを目的としたイニシアチブである「ビジョン2045」に参加できることを誇りに思っています。

詳しくはこちら

)

)

ブログを読む

ブログを読む